La configuración correcta de robots.txt es esencial para optimizar el SEO de tu sitio web. Este archivo permite a los motores de búsqueda saber qué páginas deben ser rastreadas y cuáles deben ser ignoradas. Una implementación adecuada del robots.txt ayuda a evitar el contenido duplicado y a preservar el PageRank de páginas importantes, lo que es crucial para el SEO local.

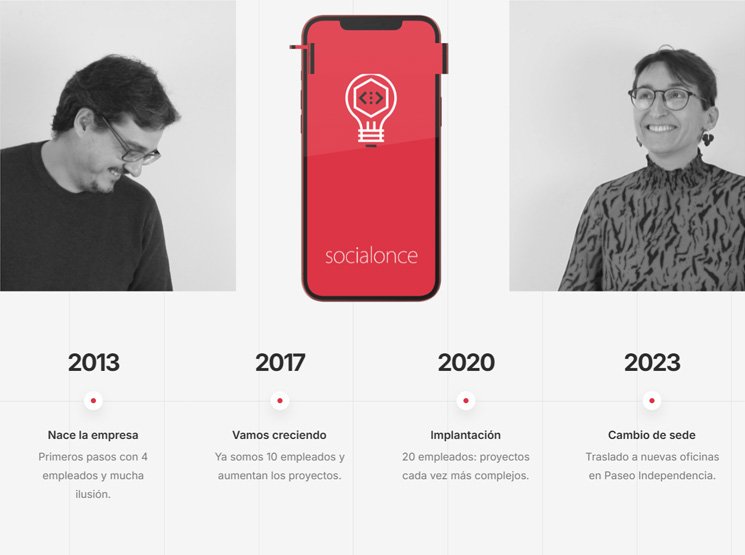

Es fundamental asegurarse de que el archivo permita el acceso a las páginas que deseas que sean indexadas, lo que mejorará tu visibilidad en los resultados de búsqueda locales. Además, prohibir el acceso a contenido irrelevante o de bajo valor ayudará a dirigir el crawl budget de manera más eficiente. Para servicios de consultoría SEO local en Oroso, www.social11.es proporciona estrategias personalizadas para optimizar la configuración de tu robots.txt y mejorar tu rendimiento en buscadores.

Recuerda que un análisis regular de este archivo es crucial para mantener la salud SEO de tu sitio. Evalúa y ajusta según las necesidades de tu negocio.